裁剪:alan学生萝莉

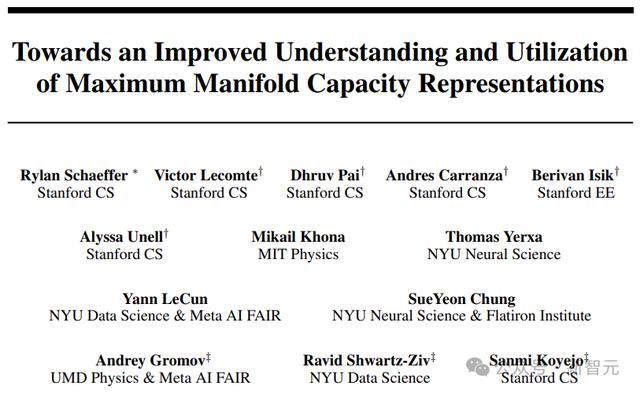

【新智元导读】近日,来自斯坦福、MIT、纽约大学和Meta-FAIR等机构的商榷东谈主员,通过新的商榷再行界说了最大流刻画量暗示法(MMCR)的可能性。

多视图自监督学习(MVSSL,或称为集结镶嵌自监督学习)是一种庞大的无监督学习顺次。它起首创建无监督数据的多个退换或视图,然后以访佛监督的方式使用这些视图来学习有用的暗示。

竣事MVSSL的具体顺次有好多,但通俗不错分为四类:对比、聚类、蒸馏/动量、冗余减少。

在这繁多的顺次中,最大流刻画量暗示(Maximum Manifold Capacity Representation,MMCR)是出类拔萃的一类。

MMCR不解确使用对比,不扩充聚类,不欺骗蒸馏,也不解确减少冗余,但遵守却不错忘形以至极度其他越过的MVSSL顺次。

而来自斯坦福、MIT、纽约大学和Meta-FAIR等机构的商榷东谈主员,正在通过新的商榷再行界说这个框架的可能性。

动作论文作家之一,LeCun也发推抒发了我方的不雅点:

除非使用防患机制,不然使用SSL进修集结镶嵌架构会导致崩溃:系统学习到的暗示信息不够丰富,以至是恒定不变的。

东谈主们想象了多种顺次来注重这种崩溃。

一类顺次是样本对比:确保不同的输入产生不同的暗示。

另一类是维度对比:确保暗示的不同变量对输入的不同方面进行编码。

两种类型的顺次都不错从信息最大化参数中派生出来:确保暗示体式尽可能多的编码关系输入的信息。

方差-协方差正则化、MMCR和MCR2(来自伯克利大学马毅团队)都是infomax维度对比顺次。

信息最大化维度对比顺次的中枢念念想,是鼓励编码器学习输入的暗示,使其尽可能充分地欺骗暗示空间,就像在有限的画布上尽可能展现丰富的细节。

为了更好地流露MMCR,商榷东谈主员欺骗高维概率器具诠释了,MMCR不错激勉学习镶嵌的对皆和均匀性。

同期,这种镶嵌最大化了视图之间的互信息的下界,从而将MMCR的几何视角与MVSSL中的信息论视角说合起来。

为了更好地欺骗MMCR,商榷东谈主员对预进修示寂的非单调变化进行数学瞻望和实验说明,发现了访佛于双下跌的活动。

此外,商榷东谈主员还发现了蓄意上的scaling law,不错将预进修示寂瞻望为梯度步长、批量大小、镶嵌维度和视图数目的函数。

最终,作家诠释了这个起首应用于图像数据的MMCR顺次,在多模态图像文本数据上相似发扬优异。

MMCR

MMCR由纽约大学数据科学中心(NYU Center for Data Science,CDS)的商榷东谈主员于2023年薄情。

该顺次源于神经科学中的有用编码假说:生物嗅觉系统通过使嗅觉表征合乎输入信号的统计数据来优化,举例减少冗余或维度。

起首的MMCR框架通过诊疗「流刻画量」(估量给定暗示空间内不错线性分离的对象类别数目的贪图)将这一目标从神经科学推广到了东谈主工神经相聚。

许多MVSSL顺次要么明确源自信息论,要么不错从信息论的角度来流露,但MMCR不同。

MMCR指出预计高维互信息已被诠释是贫苦的,且迫临互信息可能不会改善暗示。MMCR的基础在于数据流形线性可分性的统计力学表征。

不外LeCun等东谈主的这篇使命,将MMCR的几何基础与信息论旨趣说合起来,探索了MMCR的更深头绪机制,并将其应用推广到了多模态数据,举例图像文本对。

表面基础

MMCR源自关系线性二元分类器性能的经典端正。接洽D维度中的P点(数据),具有率性分派的二进制类标签;线性二元分类器概况到手对点进行分类的概率是些许?

统计力学蓄意标明,在热力学极限下,容量α= 2时会发生相变。MMCR将此端正从点推广到流形:

最小化MMCR示寂落味着最大化平均矩阵的核范数。

国产视频偷拍自拍在线直不雅上,竣工重建意味着团结数据的扫数视图都被相聚映射到换取的镶嵌,竣工均匀性意味着镶嵌均匀分散在超球面周围。

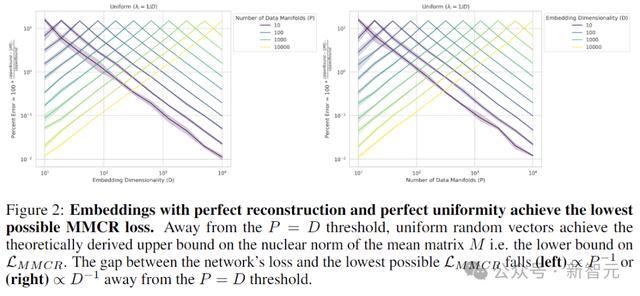

具有竣工重建和竣工均匀性的镶嵌竣事了尽可能低的MMCR示寂

基于对MMCR镶嵌分散的新订立,咱们怎样将MMCR的统计力学几何不雅点与信息论不雅点说合起来?

谜底是,MMCR激勉暗示的最大化,对应于团结数据的两个视图的两个镶嵌分享的互信息的下限。

接洽某些输入数据两个不同视图的镶嵌之间的互信息。两个视图之间的互信息必须至少与两项之和一样大:一个镶嵌重建另一个的才调,再加上镶嵌的熵:

MMCR的双下跌

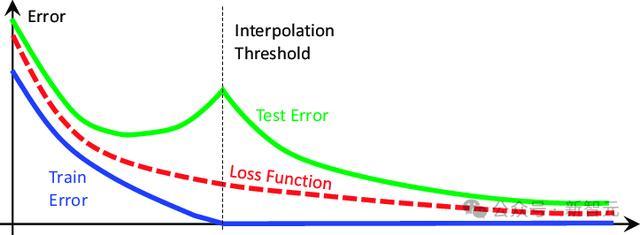

通过高维概率分析可知,瞻望最大流刻画量暗示的预进修示寂,也应该在其预进修示寂中发扬出非单调双下跌样活动。

(双下跌:测试示寂动作数据总和和模子参数数目的函数发扬出非单调变化 )。

关联词,本文的分析也标明,这种访佛双下跌的活动应该发生在非典型参数(流形的数目P和维数D)上,而不是数据的数目和模子的参数目。

具体来说,表面瞻望最高的预进修弱点应该正值发生在阈值P = D处,预进修弱点落在阈值的两侧。

为了比拟不同超参数对的点数P和数据维度D之间的示寂,这里使用MMCR预进修界限来界说预进修百分比弱点:

商榷东谈主员在STL-10上预进修了ResNet-18,STL-10是一个与CIFAR-10访佛的数据集,但区别率更高 (96x96x3),况且包含100000张图像的附加未标志分割。

扫描领域P:{64, 128, 256, 512, 1024} × D:{64, 128, 256, 512, 1024} × K:{2, 4, 8}(K为视图数),端正如上图所示。

Compute Scaling Laws

在许多MVSSL顺次中,转换超参数频繁会导致预进修示寂不终点,从而使入手之间的比拟变得贫苦。

关联词,MMCR预进修百分比弱点产生的数目介于0和1之间,因此不错将不同超参数(P和D)时的进修情况放在通盘比拟。

扩充这么的比拟会产生情理的训诫格式:蓄意MMCR预进修百分比弱点中的神经缩放定律。

通过画图在STL-10上预进修的ResNet-18相聚,咱们不错明晰地看到预进修百分比弱点的幂律缩放与扫数点数P 、镶嵌维度D和视图数目K的蓄意量的关系。

一个关键细节是这些神经缩放弧线隆起了访佛双下跌的活动:对角线子图(P = D时)具有较高的预进修百分比弱点和较小的预进修百分比斜率。

MMCR与多模态

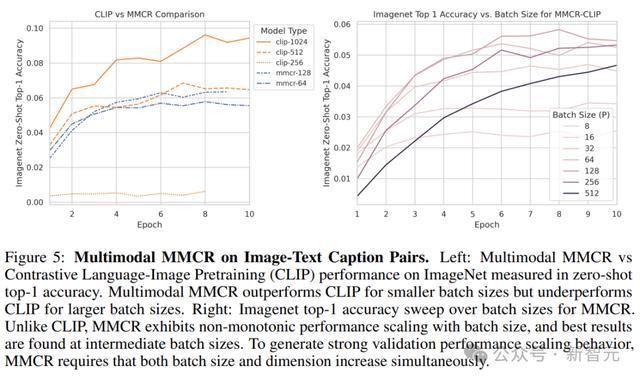

接洽OpenAI的对比谈话图像预进修模子CLIP的开采,两个不同的相聚在图像文本标题对上进行预进修,从两个不同的数据域X和Y取得数据。

X和Y是配对的,使得X中的每个示例在Y中都有对应的正对,反之也是。从MMCR角度来看,X和Y不错流露为团结底层对象的两个视图。

因此,最优变换镶嵌f(X)和g(Y)应映射到团结空间,况且咱们不错欺骗对MMCR的改良流露来进修这些最优相聚。

与常见的MVSSL不同,这里的X和Y在履行中可能代表极其不同的分散。

在上图的图像-文本对皆实验中,作家将多模态MMCR应用于DataComp-Small,并将零样本Imagenet性能与范例CLIP标的进行比拟。

不错发现,多模态MMCR在小批量(< 512)下发扬优于CLIP。

参考贵寓:

https://x.com/ylecun/status/1834666512856031537学生萝莉